El Pentágono habría utilizado a Claude, el modelo de inteligencia artificial de Anthropic, en la operación militar que terminó con la captura de Nicolás Maduro del pasado 3 de enero, según lo revelado por varias fuentes a The Wall Street Journal y Fox News, lo que marcaría un hito en la integración de dicha tecnología en esta clase de misiones.

La revelación del uso de Claude tensa las relaciones entre la empresa Anthropic y el gobierno de Trump. Esto se debe a que ambas partes arriesgan ahora un contrato con el Departamento de Defensa valorado en 200 millones de dólares, según reportan Fox News y The Wall Street Journal.

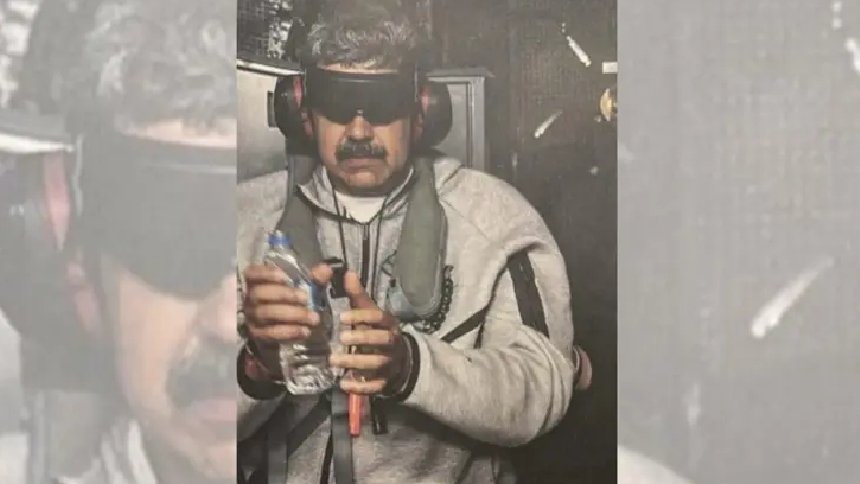

Fuerzas especiales estadounidenses ejecutaron la detención de Maduro y Cilia Flores en suelo venezolano para trasladarlos a EEUU. El operativo expuso el potencial de la IA mediante un acuerdo con Palantir Technologies, firma que provee sistemas de seguridad al Pentágono.

PALABRAS DE UN PORTAVOZ DE ANTHROPIC

Anthropic y el Departamento de Defensa evitaron confirmar su participación por temas de confidencialidad. Un portavoz de Anthropic declaró a Fox News Digital y The Wall Street Journal: “No podemos comentar si Claude, o cualquier otro modelo de IA, se usó en alguna operación específica, clasificada o no”.

La compañía subrayó que el uso de su tecnología debe respetar sus políticas internas. El mismo portavoz añadió que sus reglas prohíben expresamente “ayudar a facilitar violencia, desarrollar armas o llevar a cabo tareas de vigilancia”. Esto, sin importar si el cliente es privado o gubernamental.

Una fuente consultada por Fox News Digital afirmó que Anthropic supervisa el uso de su inteligencia artificial en entornos clasificados. Asimismo, aseguró que la empresa confía en que sus socios respetaron las normas de uso durante la misión en Venezuela.

LEA TAMBIÉN: CONTRA TODO PRONÓSTICO: LA RADICAL MEDIDA DE TRUMP SOBRE EL ID PARA VOTAR EN ELECCIONES DE MEDIO TÉRMINO

La presencia de sistemas como Claude en la seguridad nacional otorga legitimidad a las firmas de IA que buscan justificar sus valoraciones multimillonarias. Sin embargo, el despliegue militar despierta dilemas éticos y provoca renuncias de empleados que exigen un desarrollo tecnológico más responsable.

La administración Trump acusó a Anthropic de obstaculizar su estrategia de baja regulación para el sector militar. Varios funcionarios evalúan ahora cancelar el contrato con la firma debido a las restricciones que los desarrolladores imponen al hardware sensible y a las garantías de seguridad.

Entretanto, los ejecutivos de Anthropic presionan ahora para limitar el alcance bélico y de vigilancia de sus modelos. La empresa teme que el Pentágono utilice su tecnología en misiones letales autónomas o para el espionaje doméstico, según informaron diversos medios.